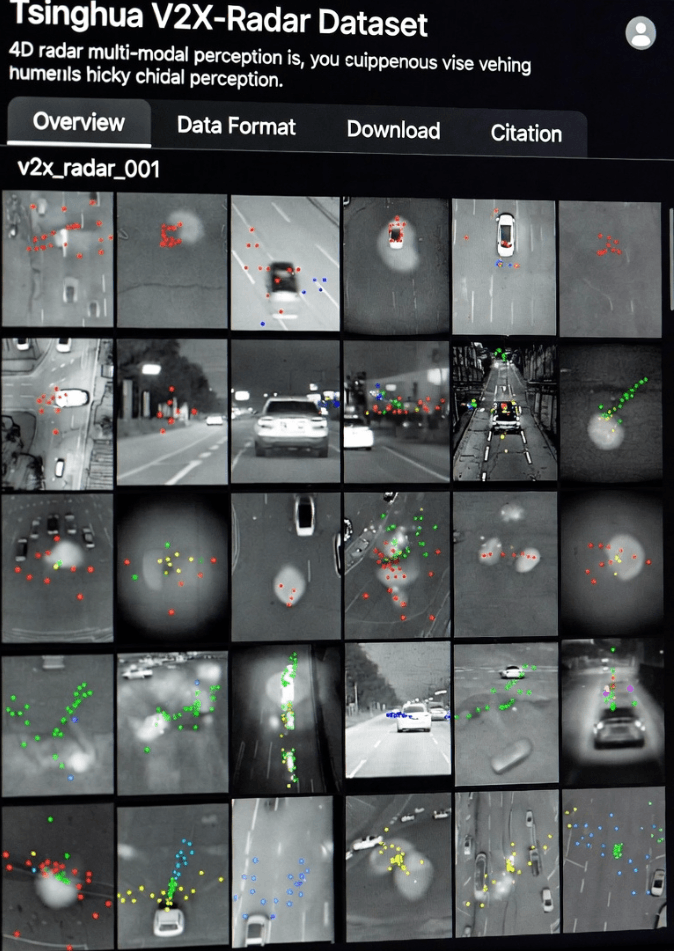

La conducción autónoma avanza rápidamente, pero la percepción del entorno sigue siendo un desafío crucial. Las soluciones basadas en un solo vehículo suelen estar limitadas por los puntos ciegos de los sensores y el alcance de detección, lo que dificulta su manejo en tráfico denso, situaciones inusuales o condiciones climáticas extremas. Para superar estas limitaciones, el Instituto de Vehículos y Movilidad de la Universidad de Tsinghua , junto con varios colaboradores, presentó el conjunto de datos V2X-Radar en NeurIPS 2025. Se trata del primer conjunto de datos a gran escala que utiliza radar 4D para la percepción vehículo-a-todo (V2X) , lo que permite la fusión de sensores multimodales y demuestra ventajas significativas en entornos complejos ( página oficial de Tsinghua V2X-Radar ).

Este conjunto de datos representa un cambio desde la percepción tradicional de un solo vehículo hacia la percepción colaborativa. Si bien la mayoría de los vehículos autónomos se basan en sensores como LiDAR , cámaras y radar de ondas milimétricas , cada tipo de sensor presenta limitaciones inherentes. El LiDAR proporciona una estructura 3D precisa, pero su rendimiento se deteriora con lluvia, niebla o nieve. Las cámaras capturan información semántica valiosa, pero dependen de la iluminación y suelen ser menos efectivas de noche o con fuerte contraluz. La integración de datos de sensores instalados en vehículos con la infraestructura vial permite una comprensión más completa y dinámica del entorno, lo que posibilita que los vehículos perciban áreas que no podrían detectar de forma independiente ( IEEE Transactions on Intelligent Transportation Systems ).

Los conjuntos de datos V2X existentes, como OpenV2V y DAIR-V2X , generalmente carecen de datos de radar 4D, lo que limita la investigación en fusión multimodal. El conjunto de datos V2X-Radar resuelve esta limitación al incorporar radar 4D junto con LiDAR y cámaras multivista, lo que permite a los investigadores explorar la fusión espaciotemporal profunda para la percepción colaborativa. Este enfoque mejora la detección en escenarios complejos, como peatones o vehículos parcialmente ocluidos en intersecciones complicadas.

Características clave del radar V2X

Fusión de sensores multimodales

Las unidades vehiculares y de borde de carretera del radar V2X incluyen LiDAR, radar 4D y cámaras multivista , que conforman capacidades de percepción complementarias. Cada sensor aporta ventajas únicas:

El LiDAR produce densas nubes de puntos, capturando la geometría de los objetos con una precisión a nivel centimétrico.

El radar 4D opera a 77/79 GHz, penetra la lluvia, la niebla y la nieve, y proporciona información de velocidad a partir de nubes de puntos dispersas ( Tecnología de radar 4D Linpowave ).

Las cámaras proporcionan imágenes RGB de alta resolución, añadiendo contexto semántico y permitiendo el reconocimiento de señales de tráfico, marcas viales y gestos de peatones.

Los experimentos demuestran que el LiDAR supera ligeramente al radar en condiciones de buena visibilidad, pero el radar 4D mantiene una mayor estabilidad en condiciones adversas, con un mAP entre un 1 % y un 2 % superior. Estos resultados confirman la utilidad de la fusión de sensores multimodales en la conducción autónoma en el mundo real.

Cobertura de escenarios diversos

Los datos se recopilaron durante nueve meses en diversos entornos, incluidos campus universitarios, vías públicas y sitios de prueba controlados. El conjunto de datos abarca:

Condiciones meteorológicas: despejado, lluvioso, con niebla, nevado

Momentos del día: día, atardecer, noche

Intersecciones complejas: calles transversales, cruces en T y zonas del campus obstruidas

Las cámaras de carretera capturan a peatones o ciclistas que no son visibles para el LiDAR instalado en los vehículos, proporcionando datos valiosos para el entrenamiento en escenarios extremos ( Conjunto de datos CAV del MIT ). Estos escenarios son cruciales para desarrollar algoritmos de conducción autónoma robustos que puedan gestionar eficazmente los casos límite.

Soporte multitarea

El radar V2X se divide en tres subconjuntos para respaldar diferentes líneas de investigación:

V2X-Radar-C: detección colaborativa de objetos 3D que combina datos de vehículos y de la vía pública.

V2X-Radar-I: percepción solo en carretera

V2X-Radar-V: percepción local del vehículo

Los modelos colaborativos como V2X-ViT alcanzan un mAP del 53,61 % al fusionar LiDAR y radar 4D, superando significativamente a los modelos LiDAR de modalidad única (47,23 %). Esto demuestra que la fusión multimodal mejora la robustez de la percepción, especialmente en entornos complejos u ocluidos.

Sincronización de sensores

La alineación precisa de los sensores es esencial para la percepción colaborativa. El radar V2X utiliza la sincronización GPS/IMU y el registro de nubes de puntos basado en características:

Sincronización horaria: Las señales GNSS y los intervalos de tiempo logran una alineación a nivel de nanosegundos entre el vehículo y las unidades de borde de carretera.

Alineación espacial: El LiDAR y las cámaras se calibran utilizando patrones de tablero de ajedrez; el LiDAR y el radar 4D utilizan reflectores de esquina, logrando una precisión a nivel centimétrico.

Esto garantiza una fusión multisensor fiable incluso en escenarios de tráfico dinámicos, proporcionando una base sólida para la investigación en percepción V2X .

Detalles técnicos

Escala y anotación de datos

El conjunto de datos contiene 540.000 fotogramas multimodales :

20.000 fotogramas LiDAR

40.000 fotogramas de cámara

20.000 fotogramas de radar 4D

Incluye 350 000 cajas delimitadoras 3D anotadas que abarcan automóviles, camiones, autobuses, ciclistas y peatones. La anotación se realiza mediante herramientas semiautomáticas, con una corrección manual mínima, lo que garantiza datos de referencia de alta calidad para el desarrollo de algoritmos.

Validación de algoritmos

El radar V2X plantea dos desafíos técnicos principales:

Retardo de comunicación: Un retardo fijo de 100 ms reduce el mAP entre un 13,3 % y un 20,49 % para métodos como F-Cooper, lo que destaca la importancia de las redes de baja latencia.

Fusión multimodal: La combinación de LiDAR y radar 4D mejora el mAP hasta el 53,61% en condiciones climáticas adversas, lo que demuestra los beneficios de la complementariedad intermodal.

Los algoritmos de compensación espaciotemporal reducen aún más los errores temporales, mejorando la robustez de los modelos de percepción colaborativa.

Aplicaciones y direcciones futuras

El radar V2X aporta valor en varias áreas:

Pruebas de algoritmos: apoya la investigación en fusión de LiDAR y radar 4D y detección colaborativa

Estándares de la industria: establece directrices para la sincronización y anotación multimodal.

Potencial comercial: La penetración del radar 4D reduce los costes de despliegue en ciudades inteligentes, puertos y aplicaciones logísticas.

Los planes futuros incluyen la integración del seguimiento de múltiples objetos, la predicción de trayectorias y pruebas de redes C-V2X en el mundo real, acelerando la transición de la investigación de laboratorio al despliegue en el mundo real.

Preguntas frecuentes

P1: ¿Qué es el radar 4D?

A1: El radar 4D proporciona información de distancia, ángulo y velocidad en tiempo real, lo que permite la detección de objetos en movimiento en entornos complejos ( referencia MDPI ).

P2: ¿Qué tareas puede soportar el radar V2X?

A2: Detección colaborativa, percepción solo en el borde de la carretera, percepción local del vehículo, fusión multimodal y seguimiento de múltiples objetos.

P3: ¿Cómo pueden los investigadores acceder al conjunto de datos?

A3: Las solicitudes se realizan a través de la Universidad de Tsinghua ( página oficial de V2X-Radar ).

P4: ¿Por qué es importante la fusión multimodal?

A4: La combinación de LiDAR, radar 4D y cámaras reduce los puntos ciegos, mejora el rendimiento en condiciones climáticas adversas y captura objetos ocluidos.

Conclusión

El conjunto de datos V2X-Radar representa un hito en la percepción para la conducción autónoma. La combinación de radar 4D con LiDAR y cámaras permite abordar problemas complejos que los sistemas de un solo vehículo no pueden resolver. A medida que los vehículos autónomos avanzan hacia la automatización de nivel 4/5, V2X-Radar podría transformar el panorama de la tecnología de percepción y abrir nuevas posibilidades para el transporte inteligente.

Para obtener más información sobre el radar de ondas milimétricas 4D en la percepción V2X, consulte los productos de radar 4D de Linpowave .