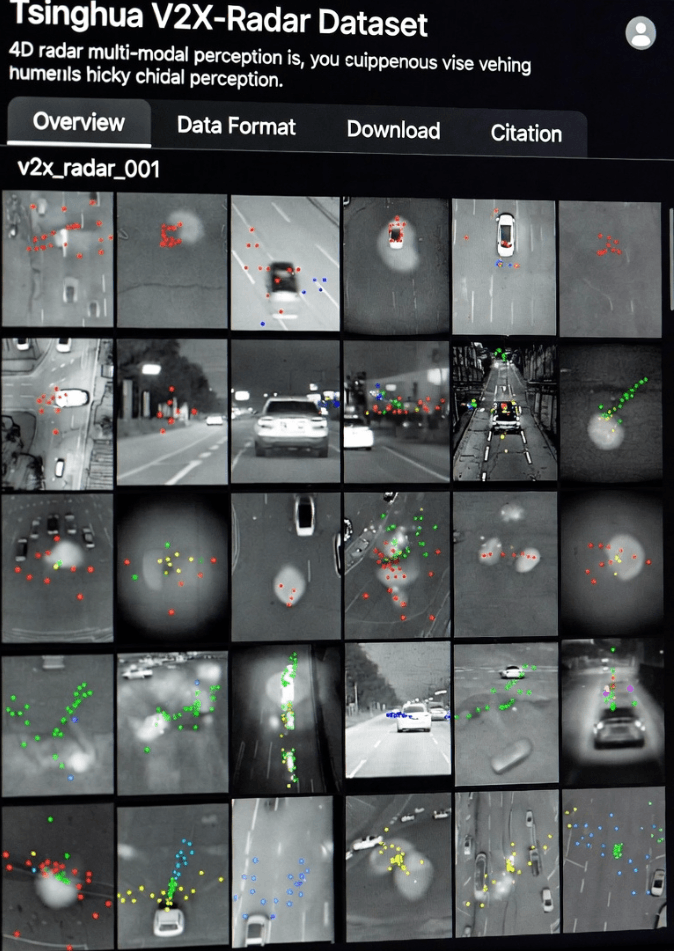

自动驾驶技术发展迅猛,但环境感知仍然是一项关键挑战。单车解决方案通常受限于传感器盲区和探测范围,难以应对拥堵路况、异常场景或极端天气条件。为了克服这些限制,清华大学车辆与移动出行研究院联合多个合作方在NeurIPS 2025上发布了V2X-Radar数据集。这是首个利用4D 雷达进行车联网 (V2X) 感知的大规模数据集,支持多模态传感器融合,并在复杂环境中展现出显著优势( 清华 V2X-Radar 官方页面)。

该数据集代表了从传统的单车感知向协同感知的转变。虽然大多数自动驾驶车辆依赖于激光雷达、摄像头和毫米波雷达等传感器,但每种传感器都有其固有的局限性。激光雷达能够提供精确的三维结构信息,但其性能在雨、雾或雪等天气条件下会下降。摄像头能够捕捉丰富的语义信息,但其性能依赖于光照,在夜间或强逆光条件下通常效果不佳。将车载传感器的数据与路侧基础设施的数据相结合,可以更全面、更动态地理解周围环境,使车辆能够感知到它们独立无法探测到的区域( IEEE智能交通系统汇刊)。

现有的V2X数据集,例如OpenV2V和DAIR-V2X ,通常缺乏4D雷达数据,限制了多模态融合的研究。V2X -Radar数据集通过将4D雷达与激光雷达和多视角摄像头相结合来弥补这一不足,使研究人员能够探索用于协同感知的深度时空融合。这种方法提高了在长尾场景(例如复杂路口处部分遮挡的行人或车辆)中的检测性能。

V2X雷达的主要特点

多模态传感器融合

V2X雷达中的车辆和路侧单元包括激光雷达、4D雷达和多视角摄像头,它们形成互补的感知能力。每个传感器都贡献了独特的优势:

激光雷达生成密集的点云,以厘米级的精度捕捉物体的几何形状。

4D 雷达工作频率为 77/79GHz,可穿透雨、雾和雪,并提供来自稀疏点云的速度信息( Linpowave 4D 雷达技术)。

摄像头提供高分辨率 RGB 图像,增加语义上下文,并能够识别交通标志、车道线和行人手势。

实验表明,在晴朗天气下,激光雷达的性能略优于传统雷达;但在恶劣天气条件下, 4D雷达的稳定性更佳,平均精度均值(mAP)高出1%至2%。这些结果证实了多模态传感器融合在实际自动驾驶应用中的价值。

多样化的场景覆盖

数据采集历时九个月,涵盖多种环境,包括大学校园、公共道路和受控测试场地。数据集包含以下内容:

天气状况:晴朗、下雨、有雾、下雪

一天中的时间:白天、黄昏、夜晚

复杂交叉路口:十字路口、丁字路口和校园内被遮挡区域

路边摄像头可以捕捉到车载激光雷达无法探测到的行人或骑行者,为长尾场景训练提供宝贵数据( MIT CAV 数据集)。这些场景对于开发能够有效处理极端情况的稳健自动驾驶算法至关重要。

多任务支持

V2X-Radar分为三个子集,以支持不同的研究方向:

V2X-Radar-C:结合车辆和路侧数据的协同式三维目标检测

V2X-Radar-I:仅限路侧感知

V2X-Radar-V:车辆局部感知

诸如V2X-ViT之类的协同模型在融合激光雷达和4D雷达数据时,平均绝对精度(mAP)达到了53.61%,显著优于单模态激光雷达模型(47.23%)。这表明多模态融合能够提高感知鲁棒性,尤其是在复杂或遮挡的环境中。

传感器同步

传感器的精确对准对于协同感知至关重要。V2X-Radar 使用 GPS/IMU 授时和基于特征的点云配准:

时间同步: GNSS 信号和时间盒实现了车辆和路侧单元之间的纳秒级对准。

空间对准:激光雷达和相机使用棋盘格图案进行校准;激光雷达和 4D 雷达使用角反射器,可达到厘米级精度。

这确保了即使在动态交通场景下也能可靠地进行多传感器融合,为V2X感知的研究奠定了坚实的基础。

技术细节

数据尺度和注释

该数据集包含540,000 个多模态帧:

20,000帧激光雷达图像

40,000 帧相机画面

20,000 个 4D 雷达帧

它包含35万个带标注的3D边界框,涵盖汽车、卡车、公共汽车、自行车和行人。标注工作采用半自动化工具完成,仅需少量人工校正,从而确保为算法开发提供高质量的真实数据。

算法验证

V2X雷达暴露出两大主要技术挑战:

通信延迟: 100 毫秒的固定延迟会使 F-Cooper 等方法的 mAP 降低 13.3%-20.49%,这凸显了低延迟网络的重要性。

多模态融合:将激光雷达和 4D 雷达相结合,在恶劣天气下将 mAP 提高到 53.61%,显示出跨模态互补的优势。

时空补偿算法进一步减少了时间误差,增强了协同感知模型的鲁棒性。

应用及未来方向

V2X雷达在多个方面具有价值:

算法测试:支持激光雷达和4D雷达融合以及协同检测方面的研究

行业标准:制定多模态同步和标注的指导原则

商业潜力: 4D雷达穿透技术可降低智慧城市、港口和物流应用领域的部署成本。

未来的计划包括整合多目标跟踪、轨迹预测和真实世界的 C-V2X 网络测试,加速从实验室研究到实际部署的过渡。

常问问题

问题1:什么是4D雷达?

A1:4D 雷达可实时提供距离、角度和速度信息,从而能够在复杂环境中检测移动物体( MDPI 参考)。

Q2:V2X-Radar 可以支持哪些任务?

A2:协同检测、仅路边感知、车辆局部感知、多模态融合和多目标跟踪。

Q3:研究人员如何访问数据集?

A3:请求通过清华大学( V2X-Radar 官方页面)提出。

Q4:为什么多模态融合很重要?

A4:结合激光雷达、4D雷达和摄像头,可以减少盲区,提高在恶劣天气下的性能,并捕捉被遮挡的物体。

结论

V2X-Radar数据集是自动驾驶感知领域的一个里程碑。它将4D雷达、激光雷达和摄像头相结合,解决了单车系统无法解决的长尾问题。随着自动驾驶汽车向L4/L5级自动化迈进,V2X-Radar有望重塑感知技术格局,并为智能交通开辟新的可能性。

有关 V2X 感知中的4D 毫米波雷达的更多信息,请参阅Linpowave 4D 雷达产品。